Was steckt in meinen Daten? – Über Datenarten, Informationsgehalt und die Tücken der Stichprobengröße

Nicht alle Daten sind gleich. Und nicht jede Auswertung erzählt eine zuverlässige Geschichte – besonders dann, wenn wir uns über die Grundlagen nicht im Klaren sind. Wer Daten analysieren will, sollte sich zuerst eine einfache, aber zentrale Frage stellen: Welche Art von Information liegt eigentlich vor – und wie viel sagt sie aus?

Die vier Datenarten – und was sie leisten können

In der Statistik unterscheiden wir vier zentrale Datenarten: nominal, ordinal, intervall- und verhältnisskaliert.

Nominale Daten sind reine Kategorien – etwa „i.O.“ / „n.i.O.“, Farben oder Produktvarianten. Sie lassen keine Reihenfolge zu und enthalten nur sehr begrenzte Information. Ordinale Daten wie Schulnoten oder Ranglisten erlauben zumindest eine Reihenfolge, aber die Abstände zwischen den Stufen sind nicht genau definiert.

Intervallskalierte Daten, zum Beispiel Temperatur in Celsius, ermöglichen die Interpretation von Abständen zwischen Werten. Doch ohne einen absoluten Nullpunkt sind Verhältnisaussagen – wie „doppelt so warm“ – nicht sinnvoll. Erst verhältnisskalierte Daten, wie Zeit, Gewicht oder Länge, erlauben das gesamte Spektrum statistischer Analysen, inklusive Mittelwerte, Streuungen und Verhältnisbildungen.

Bewertungssysteme – als ich plötzlich besser wurde

Wie sehr ein Bewertungssystem unsere Wahrnehmung beeinflusst, habe ich selbst in der Schule erlebt. In der 10. Klasse gab es klassische Noten: Eine „2“ deckte beispielsweise alles von 80 % bis 94 % ab – ein enormer Bereich. Als ich in die Oberstufe wechselte, änderte sich das System auf eine 15-Punkte-Skala: Für 85 % gab es nun 13 Punkte – was einer 1- entsprach. Bei einer Quote von 88 % bekam ich in der Sekundarstufe I also eine mittlere 2 und in der Sekundarstufe II eine 1-. Das zeigt sehr gut, wie Schulnoten Leistungen zwar ranken können – als Absolutmaß aber schwierig sind.

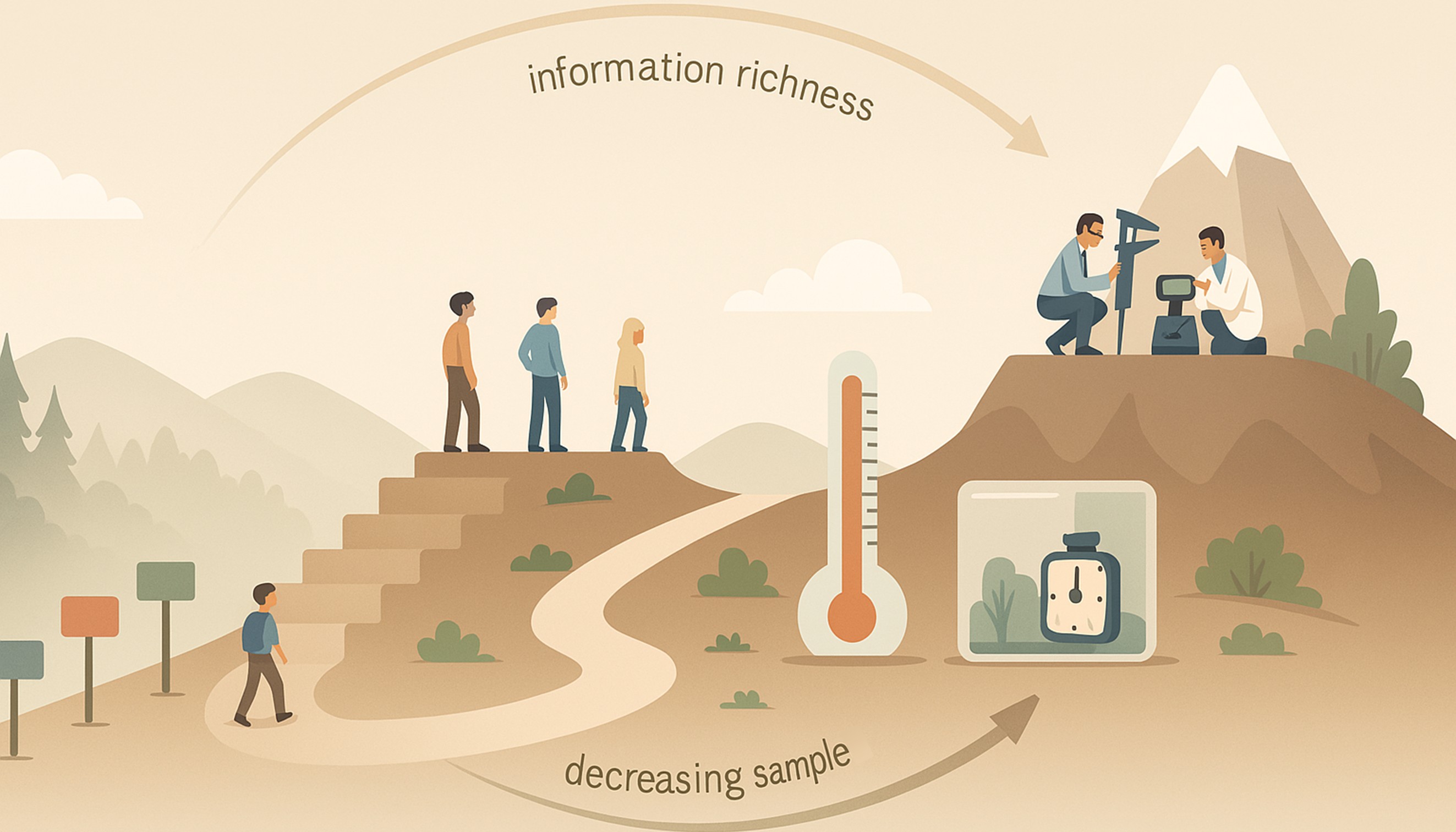

Informationsgehalt und Stichprobengröße – Qualität braucht Tiefe

Daten mit niedriger Informationsdichte – wie nominale Merkmale – benötigen oft große Stichproben, um statistisch belastbare Aussagen zu treffen. Ein „i.O.“ / „n.i.O.“ liefert pro Beobachtung nur ein Bit an Information. Will man Veränderungen im Prozess erkennen, braucht man viele solcher Datenpunkte, um ein klares Bild zu bekommen.

Bei verhältnisskalierten Daten ist das anders. Man stelle sich eine Produktionslinie vor, bei der der Ausschuss bislang nur als „unter 2 %“ oder „über 2 %“ dokumentiert wurde. Die Daten wirken stabil. Doch sobald man die exakten Ausschussprozente aufzeichnet, zeigt sich ein kontinuierlicher Anstieg von 0,8 % auf 1,9 %. Formell ist noch alles „im Rahmen“ – faktisch steht man am Rande einer kritischen Entwicklung. Eine feinere Skala offenbart, was grobe Klassifizierungen verstecken.

Fazit: Verstehen, was Daten wirklich sagen

Daten sind nicht gleichbedeutend mit Erkenntnis. Erst wenn wir ihre Struktur und ihren Informationsgehalt verstehen, können wir sinnvolle Schlüsse ziehen. Wer seine Daten richtig einordnet, wählt die passenden Analysemethoden, spart Zeit und Ressourcen – und erkennt Veränderungen, bevor sie zur Krise werden.

Denn am Ende entscheidet nicht nur, wie viele Daten wir haben – sondern vor allem, wie viel sie uns sagen.

Weitere Inhalte

Kennst Du schon LeanMarketPlace?

-

Angebote unterschiedlichster Anbieter von A-Z

-

Platziere Dein eigenes Angebot hier

-

Finde geeignete Angebote für Dein LeanProjekt

Digitales Shopfloor Management

Erlebe, wie Dein Shopfloor Management in Echtzeit zum Leben erwacht! Mit dem Digital Teamboard erhältst Du sofortigen Zugriff auf alle relevanten Daten, automatisierst wichtige Prozesse und machst einen großen Schritt in Richtung operativer Exzellenz.

Manufacturing Execution System

Ihr SaaS-Produkt für schnelle, kostengünstige und zuverlässige Produktions- und Betriebsdaten. Als führendes MES profitieren Sie von einfacher Handhabung, schneller Implementierung und umfassender Datenanalyse für optimale Fertigungsaufträge.

Weitere Inhalte auf LeanPublishing

Die erfolgreiche Transformation ist keine Frage der Technologie

Die nächste industrielle Revolution steht angeblich schon an der Türschwelle und verheißt Wunder: Industrie 4.0, Arbeiten 4.0 und Management – natürlich 4.0. Die technologischen Entwicklungen …

#JanineFragtNach bei Conny Dethloff

#JanineFragtNach bei Conny Dethloff, Business Intelligence Division Manager bei der OTTO GmbH & Co. KG und außerdem schreibender Mathematiker und Organisationsforscher.

#JanineFragtNach bei Michael Vetter

#JanineFragtNach bei Michael Vetter, Datenliebhaber und Geschäftsführer der Iodata GmbH in Karlsruhe

Restrukturierung und Lean-Einführung bei Terex Compact Germany in Crailsheim

Im Rahmen einer Restrukturierung wurde bei TEREX Compact Germany das Unternehmen neu aufgestellt. Was bedeutet, dass die Anzahl der Standorte von vier auf zwei reduziert und die Organisation …

Kommentare

Bisher hat niemand einen Kommentar hinterlassen.

Kommentar schreiben

Melde Dich an, um einen Kommentar zu hinterlassen.

Teilen